MOMUE: Manipulación Móvil para Entornos Exteriores no Estructurados

- Investigadores: Francisco A. Candelas (IP), Santiago T. Puente, (IP), Pablo Gil, Fernando Torres.

- Técnicos contratados: Víctor de Gea, Carmen Ballester, Alejando Olivas

- Contratos predoctorales asociados al proyecto (FPI): Edison Velasco

- Colaboradores: Iván Del Pino, Miguel Ángel Muñoz, Ignacio de Loyola Páez, Julio Castaño

Este proyecto está orientado a avanzar en la investigación y el desarrollo de la manipulación robótica inteligente en entornos exteriores no estructurados, haciendo uso de un robot manipulador móvil. Aunque, en los últimos años, se ha avanzado mucho en el desarrollo de nuevos sistemas de manipulación, como pueden ser manos robóticas, y de las técnicas para controlar estas de una forma más inteligente, estos avances han estado orientados principalmente a la realización de tareas en entornos muy estructurados, donde los objetos a manipular y, sobre todo, el espacio de trabajo, están bien definidos. En cambio, la manipulación robótica en entornos dinámicos, y que por eso son poco o nada estructurados, requiere actualmente de un mayor estudio e investigación. Es en este ámbito donde se enmarca el presente proyecto, que tiene el propósito de conseguir la manipulación inteligente y autónoma de objetos durante el desarrollo de tareas complejas, en espacios abiertos exteriores que implican entornos de trabajo que cambian, y sin marcas artificiales añadidas que faciliten la localización u orientación. Además de investigar en las técnicas que permitan aplicar la manipulación inteligente sobre un sistema móvil y autónomo, en el proyecto propuesto también se considera el desarrollo de un prototipo, compuesto por un brazo robot con su manipulador robótico, instalado sobre una plataforma móvil, sobre el que se aplicarán y evaluarán las técnicas investigadas en aplicaciones reales.

Para el desarrollo del proyecto hay que considerar que, un robot que opera en un entorno de trabajo de exteriores debe ser capaz de adaptarse a un entorno dinámico y no estructurado. Por ello, la plataforma de manipulación móvil deberá incorporar sistemas sensoriales adecuados que doten al robot de la capacidad perceptiva necesaria para buscar, detectar, y manipular objetos no conocidos a priori. También será necesario dotarla de capacidades de navegación autónoma en espacios abiertos, fuera de calles o pistas señalizadas, a partir de técnicas, no sólo de localización, sino también de percepción del entorno. Así, se investigará, por una parte, en adaptar los sistemas visión, control visual y manipulación, en los que los investigadores solicitantes han trabajado anteriormente en entornos estructurados, a situaciones más flexibles, para su utilización en exteriores. Por otra parte, se abordará el problema de la navegación autónoma en los entornos abiertos no estructurados, así como, la presencia del humano para realizar una supervisión de las tareas de manipulación, si fuese necesario.

Objetivos concretos del proyecto:

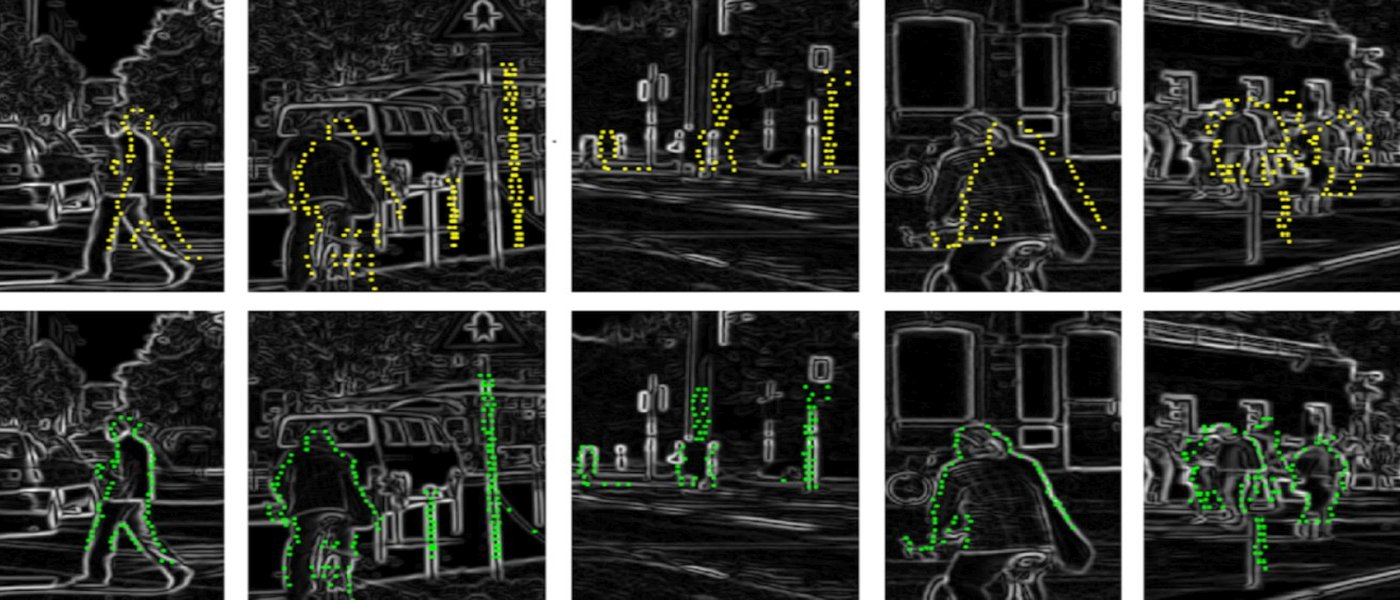

- Investigación en técnicas percepción multimodal (táctil, visión, fuerza) para agarre en entornos exteriores no estructurados. Para la realización de este objetivo, se plantea la trasferencia del conocimiento del grupo de investigación en manipulación de objetos para entornos industriales y conocidos a su extrapolación a entornos no estructurados. Para ello se partirá de las técnicas de manipulación diestra basadas en selección de puntos de agarre para objetos estáticos, y se crearán algoritmos de visión/táctil con aprendizaje para adaptar la pose del manipulador robótico y llevar a cabo un agarre óptimo del objeto, independientemente de su material de fabricación (rígido, flexible), de la textura de su superficie (rugoso, liso) y de las vistas disponibles (vistas parciales por oclusiones, iluminación, geométricas).

- Investigar en nuevas técnicas para el posicionado de un manipulador móvil para ejecutar agarre y transporte de objetos en entornos no estructurados. Este objetivo busca profundizar en las técnicas que permiten un posicionamiento conjunto de la plataforma móvil y del brazo manipulador que monta, haciendo uso del sistema multisensorial de la plataforma (propioceptivos y exteroceptivos). Para ello se van a desarrollar métodos basados en técnicas de visión 2D/3D, aprendizaje automático y control visual que permitan monitorizar el posicionamiento de los objetos durante las tereas de acercamiento y agarre.

- Investigación en sistemas de planificación y ejecución de misiones. Este objetivo contempla la planificación a alto nivel de las tareas necesarias para llevar a cabo misiones de recogida de objetos en exteriores, así como, la ejecución de las acciones para realizarlas. Las tareas incluyen la localización, agarre y transporte de objetos en espacios abiertos, mientras que las acciones consideran los algoritmos para localizarse y posicionarse (estimación de trayectorias) en un entorno cambiante (escenas con elementos dinámicos). Para ello se hará uso de técnicas de percepción móvil de cara a detectar elementos estáticos y dinámicos que alteren la percepción del mapa de la escena, y de esta manera, conseguir que la plataforma replanifique las acciones necesarias para completar la misión según las especificaciones del operador.

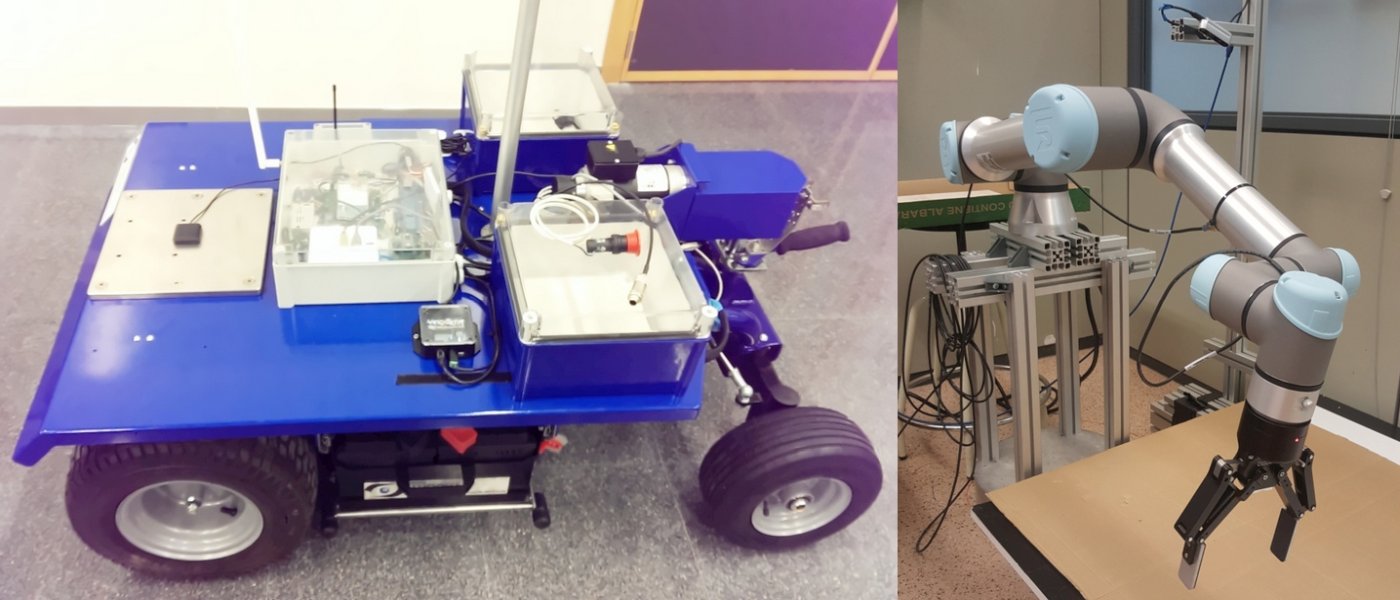

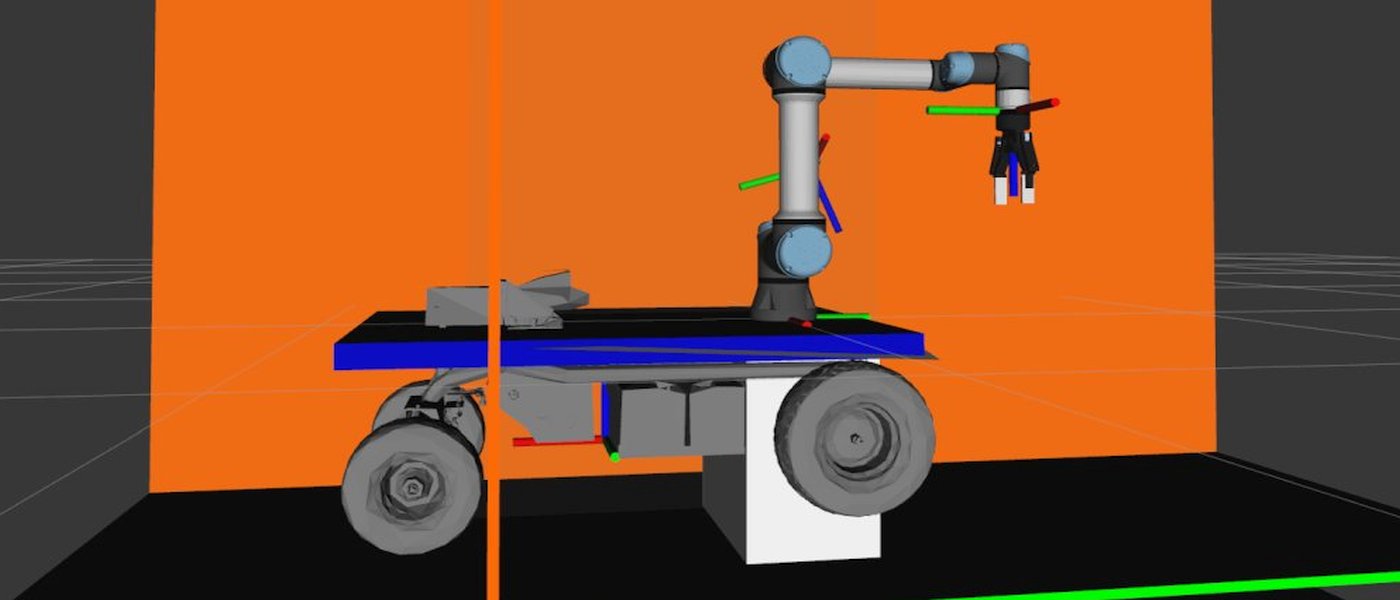

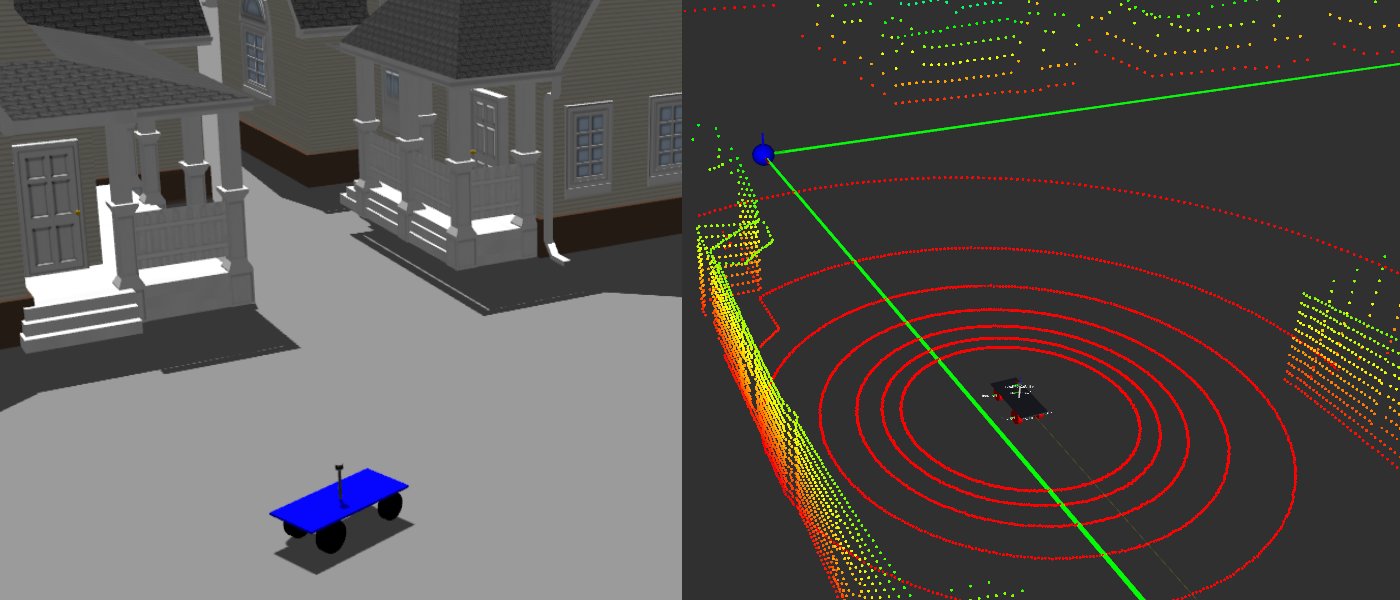

- Diseño y puesta en marcha de una plataforma de manipulación móvil en entornos exteriores. Aunque este objetivo no se planteaba como tal en la solicitud del proyecto, se trata de una tarea importante y necesaria para abordar la parte experimental y de aplicación del proyecto y así completar los otros objetivos. Consiste en la adaptación de una plataforma móvil (BLUE) disponible en el grupo de investigación solicitante, y apta para desenvolverse en entornos de exteriores, de forma que incorporase un brazo manipulador y la funcionalidad necesaria para llevar a cabo operaciones de manipulación móvil en entornos exteriores.

El grupo AUROVA ha aportado al proyecto el robot móvil BLUE, sobre el que se está construyendo la plataforma de manipulación móvil. BLUE ha sido desarrollado por el grupo de investigadores solicitante para abordar la investigación en robótica móvil para entornos no estructurados, y dispone de unas características muy interesantes: es un vehículo de 4 ruedas con dirección tipo Ackermann; tiene capacidad para desplazar una carga útil de hasta 600Kg a velocidades de 5Km/h; puede circular tanto por terrenos irregulares como pavimentados gracias a sus cuatro ruedas neumáticas; tiene freno de emergencia; y se alimenta a partir de 2 baterías de 70A/h que proporcionan una gran autonomía. Entre los sensores que incluye la plataforma, destacan los siguientes:

- LiDAR 3D Velodyne VLP-16 Puck. Campo de visión de 360º en horizontal con resolución de 0,2º, y 30º en vertical con resolución de 2º (16 capas).

- Receptores GNSS Ublox C94-M8P. Conjunto de dos receptores GNSS multiconstelación (GPS, GLONASS, Galileo) y enlace de radio UHF, que implementan algoritmos corrección diferencial en diferentes modos. Un receptor está instalado sobre BLUE, y el otro en una posición de coordenadas geográficas perfectamente conocidas.

- Unidad de medida inercial (IMU) MTi-630 de XSNENS. Más que una IMU, este módulo industrial es un AHRS (Attitude and Heading Reference System), dado que, además de disponer sensores para ofrecer medidas en 9 DOF (acelerómetro, giroscopio y magnetómetro), incluye un procesador que proporciona información de posición filtrada, de gran precisión y calibrada respecto a una referencia.

- Múltiples cámaras RGBD modelo RealSense D435 de Intel.

A parte de la plataforma móvil, gracias al proyecto se ha podido adquirir un brazo robótico UR5e OEM de Universal Robots. Se trata de un robot ligero que se puede instalar sobre la plataforma móvil BLUE, alimentándolo a partir de las baterías, con un espacio de trabajo que cubre un área razonable en torno a la parte trasera de la plataforma móvil, de forma que con su herramienta se podrán llevar a cabo las operaciones de manipulación. El robot ha sido equipado con un a pinza 2F-140 de Robotiq adquirida previamente por el grupo AUROVA.

Este proyecto ha logrado realizar un prototipo de plataforma robótica autónoma con manipulador incorporado que puede realizar la recogida y selección automática de basura en áreas como espacios naturales urbanos, bosques metropolitanos o áreas naturales de recreo. Este prototipo puede mejorar el mantenimiento de las citadas áreas, lo que repercute positivamente en la calidad ambiental de estas áreas y en la percepción de estas por parte de los ciudadanos. Gracias al nuevo sistema, que facilita la lucha contra la contaminación medioambiental, se avanza en el reto “Sociedades seguras” de la estrategia Europea H2020, dentro del objetivo específico de “Aumentar la resiliencia”. Dentro de los retos de la estrategia Española de Ciencia y Tecnología y de Innovación 2013-2020, los resultados del proyecto se engloban en el reto de “Seguridad, protección y defensa”, más concretamente, en la Estrategia Española de Seguridad, en el capítulo 4 “Amenazas, riesgos y respuestas”, especialmente en las actividades forestales para mantener limpias estas zonas.

De igual manera, el proyecto cumple con el objetivo Europeo H2020 “Transporte inteligente, ecológico e integrado”, en el área “Un transporte eficiente en el uso de los recursos y que respeta el medio ambiente”, y dentro de esta área, de la actividad 2, “Desarrollar equipamientos, infraestructuras y servicios inteligentes”, dado que el proyecto tiene aplicación para tareas de mantenimiento, seguimiento e inspección de manera autónoma y eficiente. Dicho reto se encuentra también contemplado en la Estrategia Española de Ciencia y Tecnología y de Innovación 2013-2020, en el reto de 4, “Transporte inteligente, sostenible e integrado”.

La investigación realizada en el proyecto ha generado conocimiento en sistemas de navegación autónomos con muy buenos valores de precisión y exactitud en la localización y navegación, en ubicaciones donde la información de GNSS-RTK y odometría del vehículo no siempre proporciona la exactitud suficiente por si sola. Además, se ha investigado en la utilización de sensores táctiles basados en tecnología óptica y cámaras RGBD, combinando la información de ambos para obtener agarres de objetos sin deslizamientos. La implementación llevada a cabo es modular y escalable, lo que nos permite escoger entre diferentes modelos entrenados para adaptarlo a las necesidades de la tarea. Además, este formato de implementación nos permitirá en el futuro mejorar la precisión de nuestro sistema con menos cambios, conforme en el estado del arte vaya progresando en mejoras en CNNS.

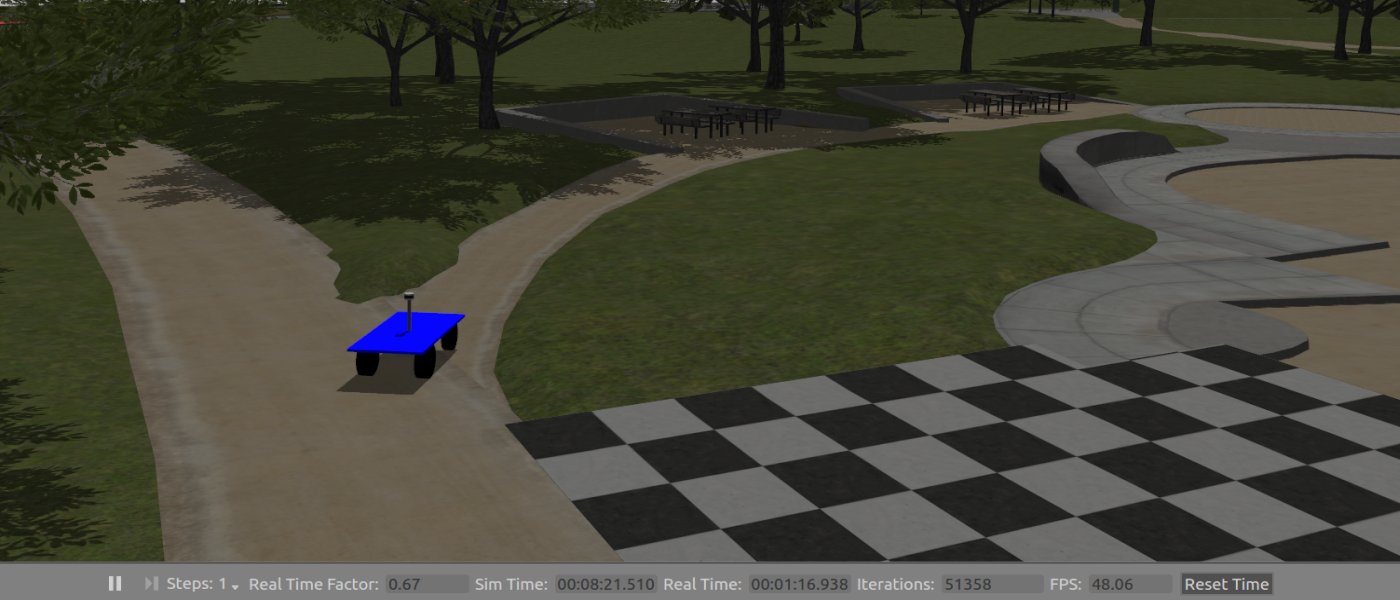

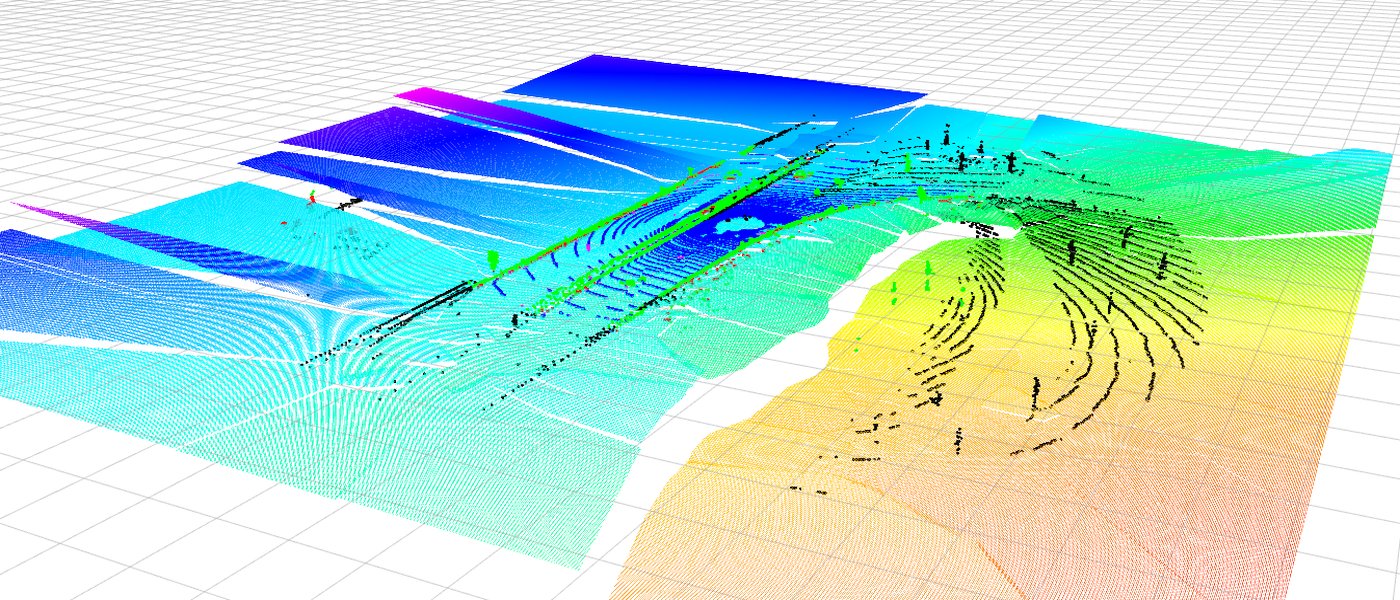

Más concretamente, en cuanto a la navegación, en primer lugar, se ha conseguido poner en marcha un sistema de localización precisa que complemente la clásica navegación basada en GNSS-RTK con una odometría basada en la información 3D captada por un sensor LiDAR en el robot. Además, se ha mejorado la localización GNSS combinando varios receptores económicos. Gracias a esto, la plataforma móvil se mantiene correctamente ubicada en momentos en que los receptores GNSS o RTK no son capaces de ofrecer la precisión necesaria. En segundo lugar, se han desarrollado un sistema de navegación por niveles que principalmente usa la información de un sensor LiDAR para lograr una navegación dinámica, capaz de replanificar las trayectorias en función de los obstáculos fijos o móviles que se encuentra el robot al tratar de seguir unas rutas previamente establecidas con puntos intermedios. Esta navegación no requiere de marcas artificiales en el entorno, ni de mapas previos detallados, ni tiene que mantener un mapa detallado del entorno como ocurre con las técnicas clásicas de SLAM, de forma que es adecuada para grandes entornos abiertos y desconocidos a priori.

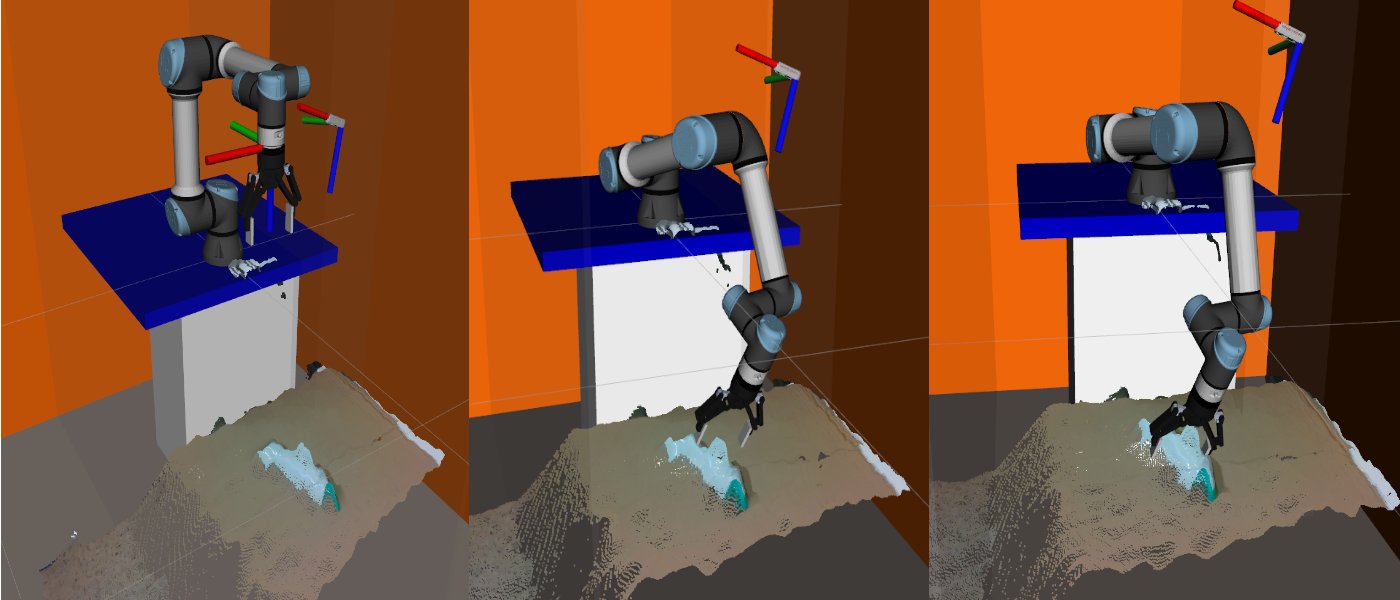

Respecto a la manipulación móvil, primero cabe destacar que se ha ideado un método que permite a la plataforma móvil detectar y localizar los objetos que es capaz de manipular en su entorno, usando algoritmos de aprendizaje profundo y reconocimiento automático, para maniobrar y aproximar el brazo manipulador frente al objeto detectado para su posterior manipulación. Esto se consigue gracias a un algoritmo de control que combina control servovisual basado en la información 3D con un control cinemático del robot. Este algoritmo funciona bien con gran independencia de la forma y perspectiva del objeto, incluso aunque este quede oculto momentáneamente, características que superan a otros métodos existentes. En segundo lugar, se ha conseguido extender métodos de planificación de agarres para objetos de los que no se dispone de modelos detallados, utilizando algoritmos de aprendizaje profundo, como YOLACT++, para la segmentación de los objetos, de forma que, una vez que la plataforma está situada correctamente, el manipulador es capaz de localizar de forma precisa y generar los puntos de agarre, así como la trayectoria del manipulador, para después recoger los objetos detectados. Con todo ello se consigue una manipulación flexible adecuada a entornos de los que no hay un conocimiento previo, lo que contrasta con la mayor parte de desarrollos en manipulación robótica que consideran entrenos altamente estructurados, o que se dispone de modelos de los objetos a manipular.

Con todo ello, la combinación de métodos de navegación en exteriores con técnicas de manipulación permite generar aplicaciones de interés, basadas en la robótica, para la mejora de la sociedad desde el punto de vista medioambiental, así como facilitar la integración de la robótica en la sociedad. Los resultados satisfactorios descritos han propiciado que los investigadores decidan continuar las líneas de investigación del proyecto MOMUE extendiendo las técnicas de navegación autónoma y manipulación móvil en entornos no estructurados a aplicaciones más complejas, con la participación en nuevos proyectos de investigación. En este sentido, cabe destacar la reciente concesión al mismo equipo investigador del proyecto “Autonomous Mobile Robots for Outdoor selective collection of household WAste” (AMROWA, PID2021-122685OB-I00), de la convocatoria de Proyectos de Generación de Conocimiento 2021 del Ministerio de Ciencia e Innovación.

Publicaciones en revistas:

- Miguel Á. Muñoz–Bañón, Iván del Pino, Francisco A. Candelas, Fernando Torres. “Framework for Fast Experimental Testing of Autonomous Navigation Algorithms”. Applied Sciences (MDPI), Special Issue Mobile Robots Navigation, 2019, Vol. 9 (10), pp. 109-131. EISSN 2076-3417. JCR Q2 en 2019. DOI: https://doi.org/10.3390/app9101997

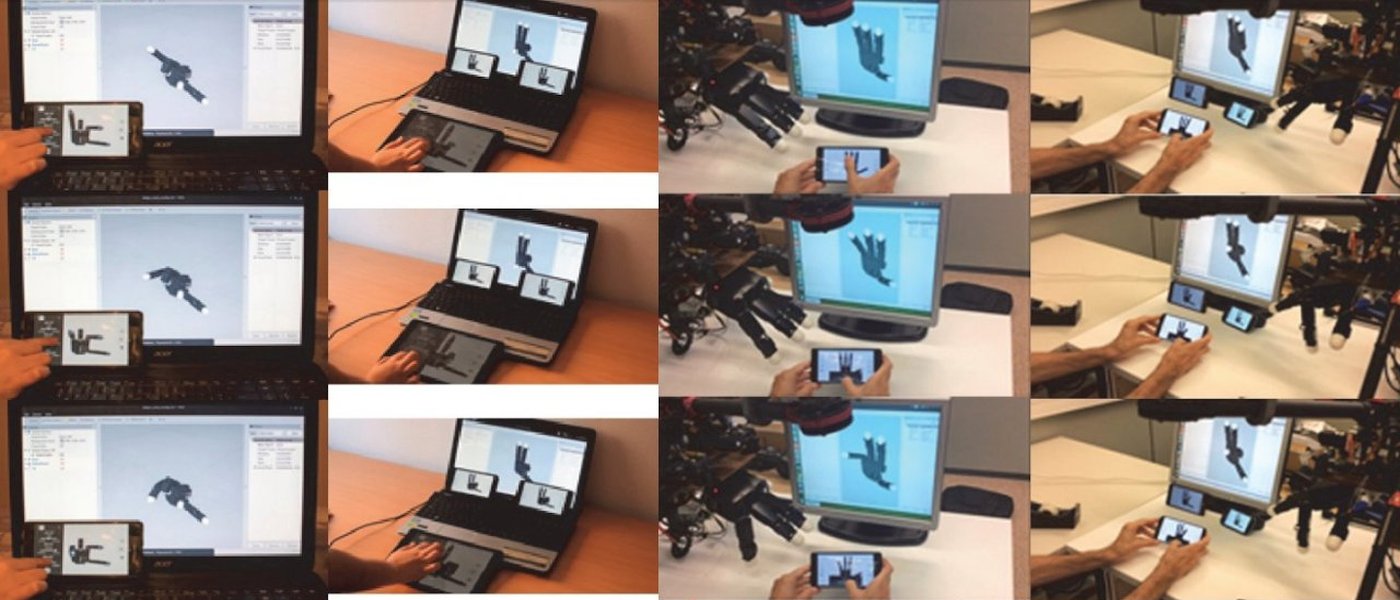

- Santiago T. Puente, Lucía Más, Fernando Torres, Francisco A. Candelas, “Virtualization of Robotic Hands Using Mobile Devices”. Robotics Special Issue Robotics in Spain 2019 (MDPI), Vol. 8, 81, 2019. ISSN 2218-6581. SJR Q2 en 2019. DOI: https://doi.org/10.3390/robotics8030081

- B.S. Zapata-Impata, P. Gil, F. Torres. “Tactile-Driven Grasp Stability and Slip Prediction”. Robotics, Special Issue Robotics in Spain 2019 (MDPI), Vol. 8(4), 85, pp. 1-20, 2019. JCR Q3 en 2019. ISSN 2218-6581. DOI: https://doi.org/10.3390/robotics8040085

- Iván del Pino, Miguel Á. Muñoz-Bañon, Saúl Cova-Rocamora, Miguel Á. Contreras, Francisco A. Candelas, Fernando Torres. “Deeper in BLUE: Development of a roBot for Localization in Unstructured Environments”. Journal of Intelligent and Robotic Systems (Springer), Vol. 98, pp. 207–225, 2020. ISSN: 0921-0296. JCR Q3 en 2020. DOI: https://doi.org/10.1007/s10846-019-00983-6

- B.S. Zapata-Impata, P. Gil, Y. Mezouar, F. Torres. “Generation of Tactile Data from 3D Vision and Target Robotic Grasps”. IEEE Transactions on Haptics, Vol. 14(1), pp.57-67, 2021. JCR Q2 en 2021. DOI: https://ieeexplore.ieee.org/document/9147076

- Miguel Ángel Muñoz-Bañon, Edison Velasco-Sánchez, Francisco A. Candelas, Fernando Torres. “OpenStreetMap-based Autonomous Navigation With LiDAR Naive-Valley-Path Obstacle Avoidance”. IEEE Transactions on Intelligent Transportation Systems, Vol23-12, 2022. JCR Q1 en 2021. https://doi.org/10.1109/tits.2022.3208829

Contribuciones a congresos:

- Puente, S.T.; Más, L.; Torres, F; Candelas, F.A. Teleoperación de manos robóticas mediante virtualización en Unity 3D para dispositivos móviles. Jornadas Nacionales de Robótica (Spanish Robotics Conference). 13-14 junio 2019, Alicante. Comunicación y presentación oral. Actas de las Jornadas Nacionales de Robótica, pp. 169-174, ISBN: 978-84-09-12133-5. 2019.

- BS Zapata-Impata, P Gil, F Torres. Predicción de la estabilidad en tareas de agarre robótico con información táctil. Jornadas Nacionales de Robótica (Spanish Robotics Conference). 13-14 junio 2019, Alicante. Comunicación y presentación oral. Actas de las Jornadas Nacionales de Robótica, pp. 249-256, ISBN: 978-84-09-12133-5. 2019.

- B.S. Zapata-Impata, P. Gil, F. Torres. Vision2tactile: Feeling Touch by Sight. Workshop on Closing the Reality Gap in Sim2real Transfer for Robotic Manipulation, Robotics Science and Systems (RSS) Conference. 23 junio 2019, Freiburg (Alemania). Comunicación y póster. DOI: http://doi.org/10.13140/RG.2.2.35906.22720. 2019.

- S.T. Puente. Manipulation of deformable objects in industrial applications. IWAR 2019 - III International Workshop on Autonomous Remanufacturing. 1 Octubre 2019, Albacete. Ponencia oral invitada. https://eventos.uclm.es/32090. 2019

- Alejandro Olivas González, P. Gil, F. Torres. Detection and Classification of Obstacles Using a 2D LiDAR Sensor. IARIA ALLSENSORS 2020 International Conference on Advances in Sensors, Actuators, Metering and Sensing. 21-25 noviembre 2020, Valencia. Comunicación y póster. ALLSENSORS 2020, pp. 63-66, ISSN: 2519-836X, ISBN: 978-1-61208-766-5. 2020.

- V. De Gea, S.T. Puente, P. Gil. Domestic waste detection and grasping points for Robotic picking up. IEEE International Conference on Robotics and Automation (ICRA 2021); Workshop Emerging paradigms for robotic manipulation: from the lab to the productive world. 30 mayo - 5 junio 2021, Xian (China). Comunicación y póster online. DOI: https://doi.org/10.48550/arXiv.2105.06825. 2021.

- Edison Velasco-Sánchez, Miguel Ángel Muñoz-Bañon, Francisco A. Candelas, Santiago T. Puente. Implementación y Evaluación de un Sistema Multi-GNSS En Un Vehículo Terrestre no Tripulado. XLII Jornadas de Automática 2021. 1-3 septiembre 2021, Castellón. Comunicación con póster. Libro de Actas de las XLII Jornadas de Automática, pp. 588-592, ISBN 978-84-9749-804-3. DOI: https://doi.org/10.17979/spudc.9788497498043. 2021.

- Autores*: Pablo Gil. Tactile perception to detect interaction and accomplish a stable grasping. IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS); 2nd Workshop on Robotic Manipulation of Deformable Objects in Real-world Applications (ROMADO-RA). 27 septiembre a 1 octubre 2021, Praga (República Checa). Ponencia oral invitada online. https://adkoessler.github.io/romadora-workshop/. 2021.

- Tornero, P.; Puente, S.; Gil, P. Detection and location of domestic waste for planning its collection using an autonomous robot. 8th International Conference on Control, Automation and Robotics (ICCAR 2022). 8‐10 abril 2022, Xiamen (China). Comunicación y presentación oral online. Proceedings IEEE ICCAR 2022, ISBN: 978-1-6654-8116-8. DOI: https://doi.org/10.1109/ICCAR55106.2022.9782609. 2022.

- Miguel Ángel Muñoz-Bañon, Edison Velasco-Sánchez, Francisco A. Candelas, Fernando Torres. Fusión de Odometría LiDAR y GNSS Mediante Transformaciones Relativas. XLIII Jornadas de Automática. 7-9 septiembre 2022, Logroño. Comunicación con póster. Libro de Actas de las XLIII Jornadas de Automática, pp. 792-297, ISBN: 978-84-9749-841-8. DOI: https://doi.org/10.17979/spudc.9788497498418. 2022.

- Julio Castaño-Amorós, Ignacio de L. Páez-Ubieta, Miguel Ángel Muñoz-Bañon, Edison Velasco-Sánchez, Francisco A. Candelas, Santiago T. Puente, Pablo Gil, Fernando Torres Torres. Desarrollos en BLUE para Manipulación Móvil en Entornos Exteriores No Estructurado

XLIII Jornadas de Automática. 7-9 septiembre 2022, Logroño. Comunicación con póster. Libro de Actas de las XLIII Jornadas de Automática, pp. 851-857, ISBN: 978-84-9749-841-8. DOI: https://doi.org/10.17979/spudc.9788497498418. 2022.

Tesis doctorales:

- Iván Del Pino Bastida. Desarrollo de un sistema completo de navegación autónoma basado en GNSS y LiDAR para robots terrestres que operan en entornos dinámicos y no estructurados. Directoresa: Fernando Torres Medina (UA), Juan Andrade Cetto (IRI-UPC). Leída el 2-9-2021.

- Miguel Ángel Muñoz Bañon. Navegación Autónoma Basada en Mapas Públicos Geo-Referenciados. Directores: Fernando Torres Medina, Francisco A. Candelas Herías. Leida el 7-12-2022.

- Edison P. Velasco Sánchez. Navegación, posicionamiento y manipulación para una plataforma robótica autónoma: Misiones en entornos dinámicos y no estructurados. Directores: Francisco A. Candelas Herías, Santiago T. Puente Méndez. En desarrollo.

- Ignacio de Loyola Páez Ubieta. Aprendizaje visual basado en demostración para manipulación robótica. Director: Santiago T. Puente Méndez. En desarrollo.